各种机器学习算法的应用场景分别是什么(比如朴素贝叶斯、决策树

另一方面将mfcc特征输入训练后的gmm-hmm模型,得到第一似然概率矩阵。模型法以图像的构造模型为基础,采用模型的参数作为纹理特征。卢卡斯认为,凯恩斯主义政策的有效性大多是根据参数固定不变的计量经济学模型,但经济当事人的理性预期将使得这些参数发生改变,从而使得政策并不能达到预期的效果。

判别分析主要是统计那边在用,所以我也不是很熟悉,临时找统计系的闺蜜补了补课。这里就现学现卖了。

atc也是自行设计生产优质音箱单元的厂家,而他们最优秀的单元就是“super linear”(超线性,简称sl)系列,不过这种sl单元造价不菲。 常见的基于核的算法包括:支持向量机(support vector machine, svm), 径向基函数(radial basis function ,rbf), 以及线性判别分析(linear discriminate analysis ,lda)等。l] [d-tropical ] 基本翻译 adj. 典型的,有代表性的 网络释义 typical:典型的,代表性的|标准的,典型的|典型的 typical odour:典型气味 typical survey:典型调查 211. wet [wet] 基本翻译57adj. 湿的 n. 潮气,雨 v. (使)弄湿 vt. 弄湿 网络释义 wet:湿,效果声信号,未加工的|湿的|潮湿 wet process:湿法|湿版洗印|湿制程 wet analysis:湿法分析|湿分析|湿式分析 212. whirl [(h)w。

=1时的狄利克雷分布生成的随机数。幸运的是,在众多的随机变量分布中,有一个“狄利克雷分布”非常适合上面列出的这些情况。14.19狄利克雷域417。

因为阿拉伯数字总共有10个,我们就要将样本分成10个类别,因此输出层我们采用10个节点。因此,我们每一个样本(手写数字的图像)可以用一个超长的784维的向量表示其特征,而用一个10维向量表示该样本所属的类别(代表的真实数字),或者叫做标签。特征提取的主要思想是将原始样本投影到一个低维特征空间,得到最能反应样本本质或进行样本区分的低维样本特征。

使用情景:

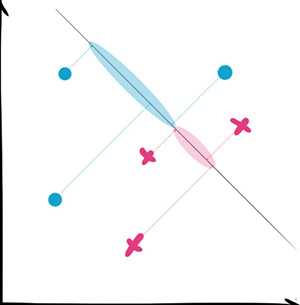

判别分析适用于高维数据需要降维的情况,自带降维功能使得我们能方便地观察样本分布。它的正确性有数学公式可以证明,所以同样是很经得住推敲的方式。

但是它的分类准确率往往不是很高,所以不是统计系的人就把它作为降维工具用吧。

同时注意它是假定样本成正态分布的,所以那种同心圆形的数据就不要尝试了。

神经网络现在是火得不行啊。它的核心思路是利用训练样本(training sample)来逐渐地完善参数。还是举个例子预测身高的例子,如果输入的特征中有一个是性别(1:男;0:女),而输出的特征是身高(1:高;0:矮)。那么当训练样本是一个个子高的男生的时候,在神经网络中,从“男”到“高”的路线就会被强化。同理,如果来了一个个子高的女生,那从“女”到“高”的路线就会被强化。

最终神经网络的哪些路线比较强,就由我们的样本所决定。

神经网络的优势在于,它可以有很多很多层。如果输入输出是直接连接的,那它和LR就没有什么区别。但是通过大量中间层的引入,它就能够捕捉很多输入特征之间的关系。卷积神经网络有很经典的不同层的可视化展示(visulization),我这里就不赘述了。

根据算法的功能和形式的类似性,我们可以把算法分类,比如说基于树的算法,基于神经网络的算法等等。世界上流行的评分模型开发方法主要分三类:非线性规划算法、统计学回归算法、神经网络算法(目前还流行随机森林、机器学习等算法应有尽有,我自己比较喜欢用l+svm的方式)。常见的算法包括:分类及回归树(classification and regression tree, cart), id3(iterative dichotomiser 3), c4.5, chi-squared automatic interaction detection(chaid), decision stump, 随机森林(random forest), 多元自适应回归样条(mars)以及梯度推进机(gradient boosting machine, gbm)。

使用情景:

数据量庞大,参数之间存在内在联系的时候。

当然现在神经网络不只是一个分类器,它还可以用来生成数据,用来做降维,这些就不在这里讨论了。

这个我是真不熟,都不知道中文翻译是什么。

它里面典型的算法是C5.0 Rules,一个基于决策树的变体。因为决策树毕竟是树状结构,理解上还是有一定难度。所以它把决策树的结果提取出来,形成一个一个两三个条件组成的小规则。

使用情景:

它的准确度比决策树稍低,很少见人用。大概需要提供明确小规则来解释决定的时候才会用吧。

接下来讲的一系列模型,都属于集成学习算法(Ensemble Learning),基于一个核心理念:三个臭皮匠,顶个诸葛亮。

翻译过来就是:当我们把多个较弱的分类器结合起来的时候,它的结果会比一个强的分类器更

典型的例子是AdaBoost。

AdaBoost的实现是一个渐进的过程,从一个最基础的分类器开始,每次寻找一个最能解决当前错误样本的分类器。用加权取和(weighted sum)的方式把这个新分类器结合进已有的分类器中。

它的好处是自带了特征选择(feature selection),只使用在训练集中发现有效的特征(feature)。这样就降低了分类时需要计算的特征数量,也在一定程度上解决了高维数据难以理解的问题。

最经典的AdaBoost实现中,它的每一个弱分类器其实就是一个决策树。这就是之前为什么说决策树是各种算法的基石。

使用情景:

好的Boosting算法,它的准确性不逊于随机森林。虽然在[1]的实验中只有一个挤进前十,但是实际使用中它还是很强的。因为自带特征选择(feature selection)所以对新手很友好,是一个“不知道用什么就试一下它吧”的算法。

同样是弱分类器组合的思路,相对于Boosting,其实Bagging更好理解。它首先随机地抽取训练集(training set),以之为基础训练多个弱分类器。然后通过取平均,或者投票(voting)的方式决定最终的分类结果。

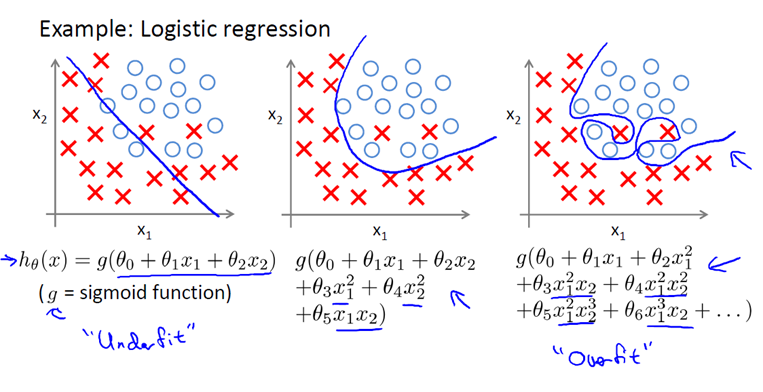

因为它随机选取训练集的特点,Bagging可以一定程度上避免过渡拟合(overfit)。

在[1]中,最强的Bagging算法是基于SVM的。如果用定义不那么严格的话,随机森林也算是Bagging的一种。

使用情景:

相较于经典的必使算法,Bagging使用的人更少一些。一部分的原因是Bagging的效果和参数的选择关系比较大,用默认参数往往没有很好的效果。

虽然调对参数结果会比决策树和LR好,但是模型也变得复杂了,没事有特别的原因就别用它了。

这个我是真不知道中文怎么说了。它所做的是在多个分类器的结果上判断回归拟合优劣程度的方法是什么,再套一个新的分类器。

这个新的分类器就基于弱分类器的分析结果,加上训练标签(training label)进行训练。一般这最后一层用的是LR。

Stacking在[1]里面的表现不好,可能是因为增加的一层分类器引入了更多的参数,也可能是因为有过渡拟合(overfit)的现象。

使用情景:

没事就别用了。

(修订:@庄岩 提醒说stacking在数据挖掘竞赛的网站kaggle上很火,相信参数调得好的话还是对结果能有帮助的。

blog.kaggle.com/2016/12/27/a-kagglers-guide-to-model-stacking-in-practice/

这篇文章很好地介绍了stacking的好处。在kaggle这种一点点提升就意味着名次不同的场合下,stacking还是很有效的判断回归拟合优劣程度的方法是什么,但是对于一般商用,它所带来的提升就很难值回额外的复杂度了。)

最近这个模型还挺流行的,主要是用来合并神经网络的分类结果。我也不是很熟,对神经网络感兴趣,而且训练集异质性(heterogeneity)比较强的话可以研究一下这个。

讲到这里分类器其实基本说完了。讲一下问题里面其他一些名词吧。

最大熵模型本身不是分类器,它一般是用来判断模型预测结果的好坏的。

3、创建类别,选择样本及分类特征,进行分类。浅层模型有一个重要的特点,需要依靠人工经验来抽取样本的特征,模型的输入是这些已经选取好的特征,模型只用来负责分类和预测。机器学习算法对test样本进行预测后,可以输出各test样本对某个类别的相似度概率。

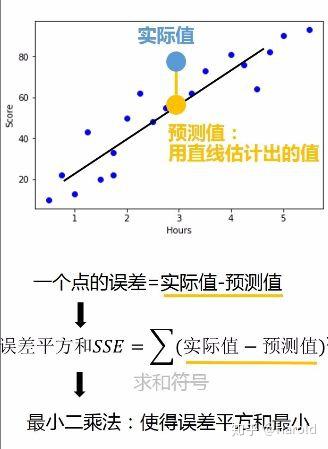

而如果这个样本真的是高的,那我们就得了一个分数60%。最大熵模型的目标就是让这些分数的乘积尽量大。

LR其实就是使用最大熵模型作为优化目标的一个算法[4]。

就像最大熵模型一样,EM不是分类器,而是一个思路。很多算法都是基于这个思路实现的。

@刘奕驰 已经讲得很清楚了,我就不多说了。

你说对了